AI是一切的基礎:也來談談交談式人機介面/Daniel Eckler

交談式操作介面(Conversational User Interface,CUI)的普及,讓人與電腦之間的溝通變得更加容易。可是……

交談式操作介面的過去與現在

如果您的年紀還不到30歲,可能會發現從前電腦操作方式,其實更像是現在電影裡面的駭客場景:

現在大家比較熟悉的電腦操作介面,是所謂的「圖形介面」(Graphical User Interface,GUI),由Xerox、Apple、以及微軟在1980年代推廣普及。更早期的電腦上只有文字模式,必須在類似上圖中的畫面上,以雙手輸入有如密碼般的指令,才有辦法跟電腦溝通。

GUI的出現,讓電腦操作更加人性而友善,也讓一般人都能輕鬆上手;目前不僅電腦,幾乎所有的個人運算設備都使用了這樣的介面。

廣義來說,GUI在多年的進化之後,雖然變得更加好用、視覺上也更賞心悅目,但並不是沒有潛在的問題;有些像是訂機票、或是訂餐廳座位的線上系統,就充斥著前後體例不一致的文字塊、下拉選單、以及位置不佳的按鈕等令人頭大的不良設計。

此外,再加上各種各樣的行動設備,它們的螢幕空間已經有限,如果再加上不良的GUI設計、要在8個畫面上點20次螢幕才能完事,很可能會把原本2分鐘就可以訂好位的過程,變成20分鐘的內心煎熬;甚至可能有人會覺得,直接翻電話簿可能還簡單一點。

現在,讓我們來考慮一下替代方案:如果可以在手機上輸入類似「下午 7 點 @Momofuku 訂 5 位」這樣的指令,會不會更方便?

編按:其實以文字輸入類似自然語言的句子,讓電腦在解析內容之後執行指令的操作方式,在1993年的蘋果Newton PDA上就已經出現了。

例如以英文輸入「明天中午跟阿花在xx餐廳吃飯」,系統就會知道明天的日期(因為當然知道今天的日期)、知道「中午」指12點、知道阿花指的是哪位(除非通訊錄中有多位阿花待選)、餐廳電話幾號(如果通訊錄中有)。

如此一來,系統在辨識這個短句之後,就會在行事曆中自動加上提醒記錄,稍後使用者也可以在行事曆中查詢阿花和餐廳的電話號碼,以便聯絡(抱歉,當時Newton還不能打行動電話、也沒有Web上網,所以只能這樣了)。

https://www.youtube.com/watch?v=f2Yliy_WUBQ

這就是最近正要開始興起的「CUI交談介面」;與其在設計不佳的介面上拼命又點又滑,還不如用這種方式和電腦溝通更加簡單明瞭。

在亞洲,許多人又會有不一樣的體驗;例如在中國相當流行的「微信」(WeChat)傳訊軟體,就將許多個西方出品商務app功能整合在一起。反過來說,許多原本應該會自己推出app或行動網站的商家,都選擇把服務放在微信之中。

事實上,許多中國的新創服務會直接在微信中起步,如此一來,就可以在這個傳訊工具中直接和顧客即時溝通。

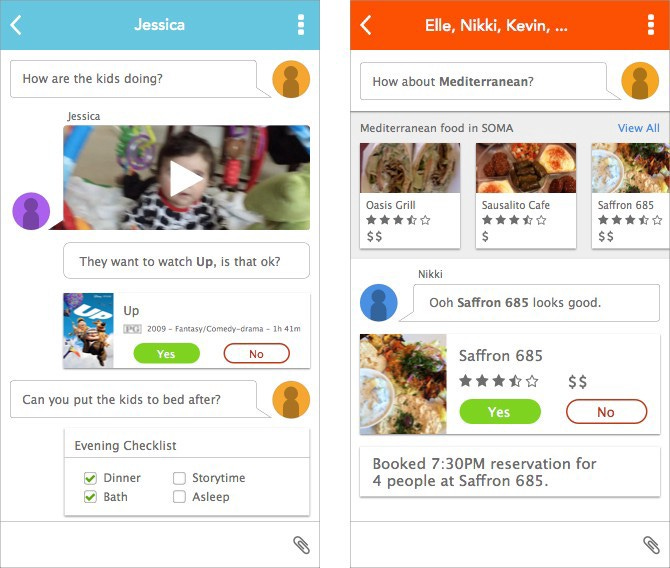

如果微信是在西方國家,大概就會長成這個樣子:

目前有許多即時傳訊平台,都開始多方運用各種媒體、並且充分運用介面的功能設計;在這些平台上,開發者可以製作各種依附在上面的小型應用,以便提供諸如媒體播放器、遊戲、小額付款、以及攝影等功能。

在北美地區,一些像是Operator這樣的公司已經開始透過CUI提供服務;使用者基本是以文字提出需求,但也可以透過視覺媒體和一些基本指令來和系統溝通。

CUI最吸引人的地方,在於讓系統可以用對話方式來接收指令、提供服務;雖然目前大多數CUI都是顧客和服務人員之間的真人對話,但人工智慧將會逐漸介入這個領域。

編按:請參閱〈我和語音機器人的第三類接觸〉一文,以及作者Evonne Wu的聊天介面開發筆記。

在理想狀況下,以後我們將可以和機器人聊自己的內心世界,而不只是聊有興趣的產品。蘋果的Siri語音功能是個好的開始,但目前我們還只是「對她說話」,而不是「跟她交談」。

在科技能夠理解像是臉部表情、說話語調、以及身體語言之類,在溝通過程中必定會發生的微妙角度之前,文字指令是更能讓人工智慧發揮的領域;或許還不像電影「雲端情人」之中,人和系統還可以談戀愛交心那麼浪漫,但文字指令算是已經在往那個方向邁進了。

[embed]https://www.youtube.com/watch?v=WzV6mXIOVl4[/embed]

模仿遊戲

科學家圖靈(Alan Turing)很早就知道,要機器能辨識、甚至模仿人類在對話中常見的微妙動作,是相當困難的; 所以,他在設計「模仿遊戲」,也就是探討機器是否能模仿人的實驗時,在這方面就給了機器比較大的空間。

現在較常被稱為「圖靈測試」(Turing Test)的這個實驗中,有A(電腦)、B(人類)、C(人類)三方共同參與;透過一系列寫成文字的問題與答案,C必須判斷出A和B之中哪個是人類、哪個是電腦。

圖靈認為,如果C在70%的對答中被電腦騙過,那就表示電腦已經有了智慧能力。

當然,在進行這個實驗的1950年代,電腦還沒有現今的語音能力,所以早期的實驗都是透過文字模式來進行的;在之後的65年之中,這個實驗依當時的科技,以各種不同的形式進行了許多次,但想要證實的核心問題還是一樣的:電腦能透過對話過程,讓我們誤以為它是人類嗎?

早期Eliza人工智慧系統的影響

早期的這類實驗之一,包括由麻省理工學院教授Joseph Weizenbaum在1966年設計的「Eliza」(參考文章);透過電傳打字機,使用者可以和這個以文學家蕭伯納作品《賣花女》主角Eliza Doolittle命名的程式交談。

Weizenbaum開發這個程式的基礎,是所謂的「個人中心治療」(Rogerian Psychotherapy)。這種療法是透過治療師以同理心詢問語氣較為被動、並且具有引導性質的問題來進行,在過程中不需要太多交談、對於談論的話題本身也不需要很深入的知識。

當使用者輸入一個句子之後,Eliza會搜尋諸如「媽媽」、「頭痛」、「家庭」之類的關鍵字,然後從龐大的資料庫中找出適當的句子來回應;如果在句子裡搜尋不到關鍵字,則會以一句普通的回應來讓對話繼續進行。

雖然Eliza淺薄的對話能力,往往在短時間內就會露出馬腳,但它具有親和力、而且被動回答的本質,一開始就廣受大眾喜愛;而設計者的一些同事和學生,甚至對它產生了強烈的情感連結。

「雖然我的秘書已經跟著我進行這個計畫一段時間,所以當然知道它只是個電腦程式,但她卻開始跟Eliza對話;而且在只有問答幾句之後,秘書就請我先離開電腦房一下。」

如同前面這段所描述的,Weizenbaum發現了一件傷腦筋的事情:人們雖然很清楚Eliza只是機器,但卻把它當作一個有智慧、而且關心他們的談話對象。現在,這個狀況被稱作「Eliza效應」;雖然被這個效應影響的案例,並非都像這位秘書那麼極端(至少他們多半沒有要求和電腦獨處),但這個結果後來卻讓Weizenbaum成為人工智慧的長期批評者。

然而,「Eliza效應」也證明了即使只是機器(在這個案例中是一部電傳打字機),如果再加上一些很基本的人性因素,也可以和人類建立一種發自內心的關係。

也就是說,只要一個很基本的對談程式,就可以把一套鍵盤和螢幕提升到接近人類的地位。

只要一點點人性元素,機器也可以和人交心。

雖然Eliza已經可以影響和它互動的人類,但它還缺少一些東西,其中最重要的是關於「情緒」和「美學」的智慧。如果我們回頭看圖靈的「模仿遊戲」,就會發現它和很多遊戲場合「男生假裝自己是女生」的玩法有異曲同工之妙。

這個遊戲的核心理念,其實就是所謂的「同理心」;如果你想讓別人相信自己是另一種性別,最好的方法就是先想著自己是那個性別、對那個性別的生活經驗產生同理心,最後才是盡可能模仿它的行為模式。

跟過去相比,現代Eliza們在技術面的進步已經不可以道里計;它們可以跟人交談好一段時間才被識破、或是達到極限。雖然它們使用的演算法已經相當先進,但卻可能完全不「理解」自己正在聽、或是正在說的話。最能證明這一點的,就是所謂的「中文房間實驗」(Chinese Room Experiment)。

在這個理論中,一位完全不懂中文的人被放在封閉的房間裡,透過一份指引資料,試圖回答從牆上小洞遞進來的中文問題。雖然這場對話從技術上看、或是從結果上看都是正確的,但房間裡的人對於交談內容到底是什麼,其實完全沒有概念。

編按:對於我們中文使用者來說,這一段影片的內容特別有趣,值得一看。影片中「懂中文」的出題者其實中文程度也不怎麼樣,但房間裡的人正因為完全不懂中文,所以對於有錯字的題目反而展現了「容錯能力」。

因為「上」和「不」長得有點像,所以光看字形還是可以找到差不多的答案;至於這兩個字在意義上的不同,對不懂中文的人或系統來說,是沒有意義的。在這類狀況下,「不懂」反而成了優點。

https://youtu.be/D0MD4sRHj1M

所以,人工智慧要克服的最後一個關卡,可能並不是圖靈所說的「騙過人類的能力」,而是如何理解接收到的資訊、進而產生出同理心的能力。在以下的影片中,人工智慧程式雖然可以進行一場似乎有意義的對話,但最後的答案卻暴露出它並不太瞭解對話內容的事實:

https://youtu.be/W0_DPi0PmF0

讓科技人性化

雖然科技圈已經有一整個領域在研究這個主題,但產業界卻是實際把這些研究加以利用、變成日常產品的重要推手。

「Amy」是一個目的非常簡單的應用軟體,主要功能就是幫你編排和管理每天的會議行程,特色則是「非常有人性」;要啟用它的功能,只需把電子郵件cc一份給它(就跟平常把信cc給助理一樣),它就知道該怎麼做了。

因為Amy可以連結你的行事曆,所以它知道你什麼時間有空;它也知道你最常用的開會場地,但如果你找到新的會議室,也可以寫封email告訴它。不過Amy最人性的一面,在於它可以在你的同意之下,接手處理後續的聯繫工作。

如您所見,Amy不只是個聊天機器人而已,它可以保留關於前次會議的資訊、並且用於對下次會議提出建議;它可以獨立運作到一定程度、也可以做出幾年前只有人類能做的「總結」。隨著CUI的進步、並且開始理解我們的行為模式, 人機之間的互動內容將會更加細緻。

諸如Google、Facebook、以及Amazon等大公司,都已經對我們在網路上、以及市場上的行為模式相當瞭解,但CUI對我們的認識將會比這些服務商更加深刻。

推動人工智慧技術進步的火車頭,是所謂的「深度學習」(deep learning);它的核心價值,在於透過工程師匯入巨量資料、並且微調系統的回應方式,來教導軟體辨識複雜型態的聲音、影像、以及其他資訊。

這項技術最知名的應用,是IBM的「Watson」系統;Watson不僅曾在美國的電視遊戲節目中獲得總冠軍,現在甚至進步到可以協助醫師進行看診和處方。

https://youtu.be/lI-M7O_bRNg

CUI感謝您的耐心等待

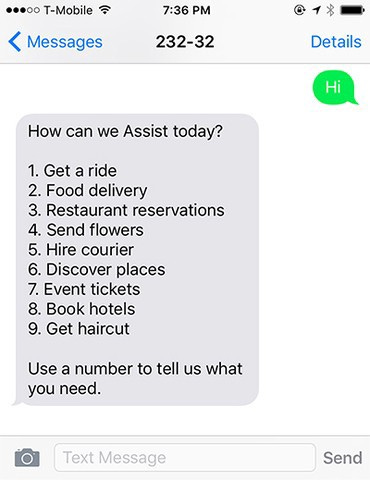

目前為止,我們已經討論了CUI未來可能如何改變人機之間的溝通方式;而我們接下來要看的,則是(尤其在現今的形式之下)可能浮現的缺點。

在上面的例子裡,原本應該是跟電腦之間的輕鬆對話,卻成了必須一一執行的待辦事項,只是電腦會幫你排好順序而已;與其如此,還不如直接自己處理掉就好,系統幫不幫忙似乎沒有什麼差別。

雖然做這套系統的公司要我們用的,也可以算是某種CUI,但是這個文字介面系統如果做成GUI圖形介面,其實也差不了多少;然而,「在手機上按號碼」這件事情,跟真正的CUI其實還有點距離。

即使可以說是目前最先進CUI的蘋果Siri語音介面,也還是有不少缺點;例如在餐廳訂位、食譜、以及導航等用途上,Siri對於話題中的細節仍然沒有任何敏銳度。在一些知名案例中,它曾經指引一位企圖自殺的人去買槍,也曾經告訴一位憂心的媽媽,她女兒的性侵事件「那不是問題」(下圖)。

以文字模式進行的溝通,當然還有很大的進步空間,而未來的語音辨識功能或許也能感受到語調的變化、進而針對其中的情緒細節做出適當回應,但像是身體語言或臉部表情方面可能都還沒有辦法。

也就是說,即使是未來的溝通介面,純文字模式仍然會佔著重要的角色。雖然CUI有著相當大的潛力,但重點在於必須搭配成熟的人工智慧技術,才能進入下一個實用階段。

人工智慧會更懂人

理論上來說,隨著人工智慧技術的進步,未來我們將有更多和機器溝通的途徑,包括文字、語音、圖形介面、體溫、以及其他跟環境或使用者個人偏好相關的方式;或許未來的機器會更瞭解我們更深,深到你眉毛一揚,它就知道你要什麼。

未來我們將有更多和機器溝通的途徑:文字、語音、圖形、甚至體溫。

舉例來說,以後我希望可以不用拿出手機發簡訊,向智慧家庭系統報告「我回來了」,而是系統應該能感應我快要到家、在到家的時候認出我的臉、並且在我手握門把的瞬間把鎖解開;如果不嫌太自我膨脹的話,希望門還可以自動打開迎接我的駕到。

現今的流行文化,也已經逐漸把這些發展融入作品之中;例如前面提過的電影「雲端情人」,只憑一聲嘆息就知道主角和媽媽之間的關係、只憑對話中的一個停頓就能解讀情緒。如果未來這些都能成真,或許代表著機器從小動作中辨識人類感性的能力,遲早會超過人類本身。

然而,現在要預測這些介面能做到什麼程度、以及會變成什麼樣子,還稍嫌早了一點;但已經有專家開始進行關於情緒資料的研究和應用。透過偵測使用者身體和行為狀況的被動感應器,電腦將會以擬人的方式逐漸累積這些資訊、並且嘗試解讀。

例如有些攝影機已經可以捕捉人類的表情、姿態、以及手勢,而麥克風和其他錄音設備則能偵測到演講中的細微轉折;同時,能偵測體溫和心跳變化的醫療器材早已存在。

總而言之,人工智慧是把這些要素串連起來的關鍵技術;它也將會讓機器在適當的時候做出正確的回應,讓我們能和機器在更深刻的層面上彼此交心。

https://youtu.be/a38EiBwJlXE